在网上看见很多问node.js如何获取客户端IP,所以记录下来,以供大家参考。

1 | function getClientIp(req) { |

代码,第一段判断是否有反向代理IP(头信息:x-forwarded-for),再判断connection的远程IP,以及后端的socket的IP。

人必有所执,方能有所成

在网上看见很多问node.js如何获取客户端IP,所以记录下来,以供大家参考。

1 | function getClientIp(req) { |

代码,第一段判断是否有反向代理IP(头信息:x-forwarded-for),再判断connection的远程IP,以及后端的socket的IP。

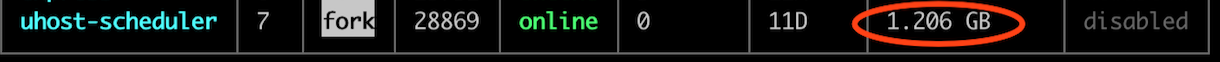

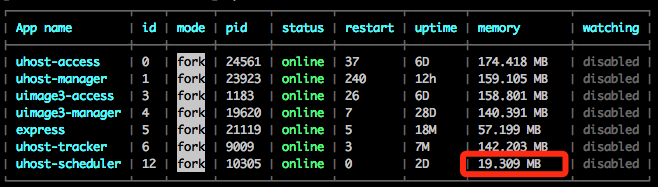

线上一个go语言写的服务,在连续跑了10多天后,占用内存从最开始的20M左右,涨到了1个多G,有内存泄漏的问题,将整个排查过程和相应方法进行整理,做个记录。

Go语言自带的pprof工具,是检测Golang开发应用性能的利器。

pprof 采样数据主要有三种获取方式:

net/http/pprof: 通过 http 服务获取Profile采样文件,简单易用,适用于对应用程序的整体监控。通过runtime/pprof实现。这里推荐这种方法

go test: 通过 go test -bench . -cpuprofile prof.cpu生成采样文件 适用对函数进行针对性测试

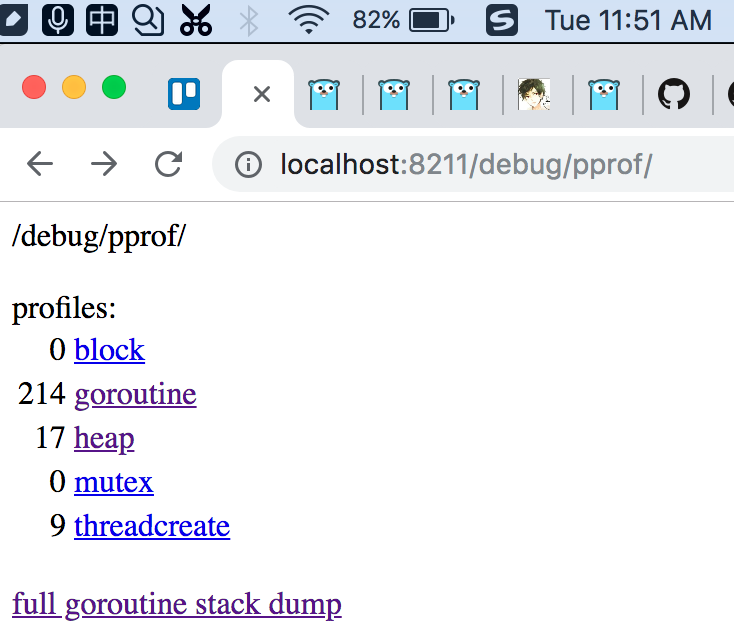

线上的服务是一直运行的,用过“net/http/pprof”可以看到实时的状态,看到各个信息指标,这里主要介绍这种方法。

1 | import _ "net/http/pprof" |

之后可以通过 http://localhost:8211/debug/pprof/CMD获取对应的采样数据

Profile翻译为“剖面,侧面等”,可以理解为当前应用的的一个剖面。可以知道哪些地方耗费了cpu、memory。

// Each Profile has a unique name. A few profiles are predefined:

goroutine - stack traces of all current goroutines

The debug parameter enables additional output.

Passing debug=0 prints only the hexadecimal addresses that pprof needs.

Passing debug=1 adds comments translating addresses to function names and line numbers, so that a programmer can read the profile without tools.

The predefined profiles may assign meaning to other debug values;

for example, when printing the “goroutine” profile, debug=2 means to print the goroutine stacks in the same form that a Go program uses when dying due to an unrecovered panic.

以上几种 Profile 可在 http://localhost:8211/debug/pprof/ 中看到,除此之外,go pprof 的 CMD 还包括,

参数具体信息可以参考http_pprof

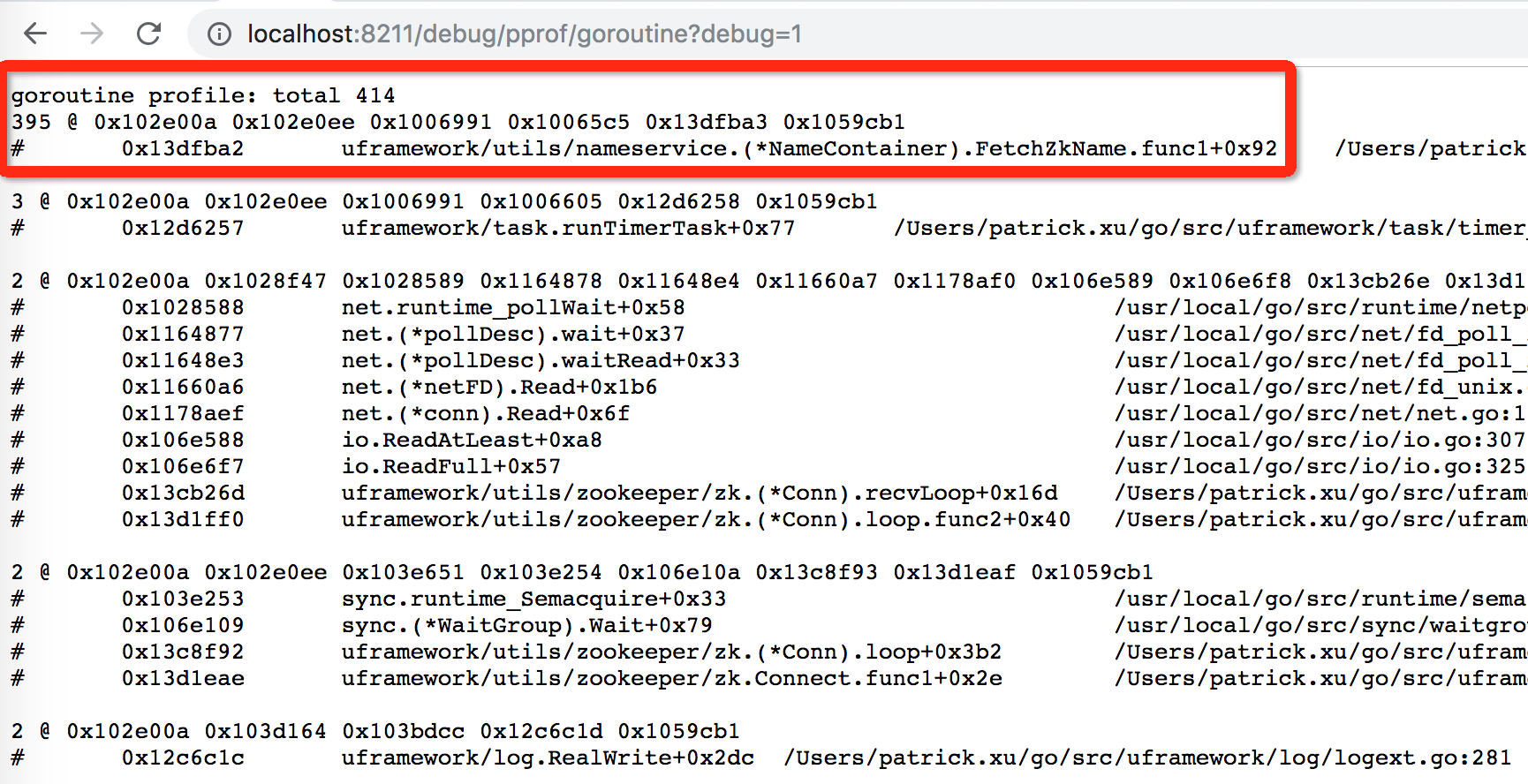

再回顾来看服务的问题,从图2中看到,goroutine的数量在一直增长;从图3看出,共起了414个goroutine, 其中395个是在调用FetchZkName。

然后再查看我们的代码,有哪里在调用go, 哪个goroutine会最终调用FetchZkName,就可以查到出问题的地方。

最终查到原因是:

1 | // 10s去更新下zk节点 |

解决方案是:UpdateInstanceFromZk()调用一次即可。

改进后,占用内存一直保持在20M左右,完美~

上面通过浏览器访问http服务的方式,需要有图形界面。而线上服务器通常是没有图形界面的,可以通过命令行方式来分析,或者将profile拷贝到本地,再生成调用关系图

支持的cmd跟net/http/pprof里提到的一样

1 | go tool pprof http://localhost:8211/debug/pprof/goroutine |

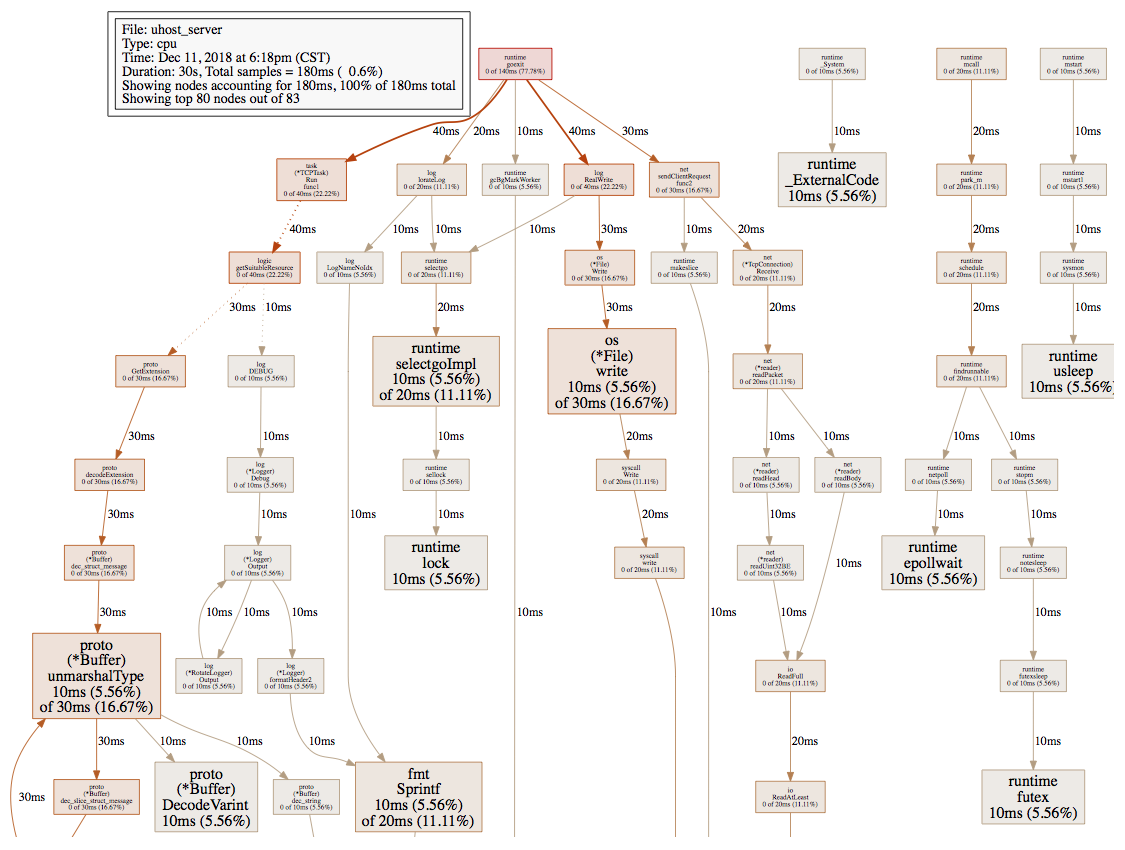

以采集CPU耗时举例,

1 | # /root/go/bin/go tool pprof http://localhost:8211/debug/pprof/profile |

会经历30s的采样时间,生成pprof.uhost_server.samples.cpu.003.pb.gz,这个可以拷贝到本地分析。

topN 命令可以查出程序最耗 CPU 的调用

1 | (pprof) top 5 |

以累加的方式,看出消耗cpu的函数运行。可以和后面图形的方式做个对比

1 | (pprof) top10 -cum |

显示函数名以及每行代码的采样分析

1 | (pprof) list dec_slice_struct_message |

显示调用图 / 显示某个具体函数的调用图

mac上需要先安装graphviz http://www.graphviz.org/

homebrew安装完毕后运行 brew install graphviz即可

1 | ➜ uhost-go git:(from_pxu) ✗ go tool pprof uhost_server pprof.uhost_server.samples.cpu.004.pb |

但是web命令生成的调用图往往是残缺的,不知道是什么原因。但找到下面更好的方式。

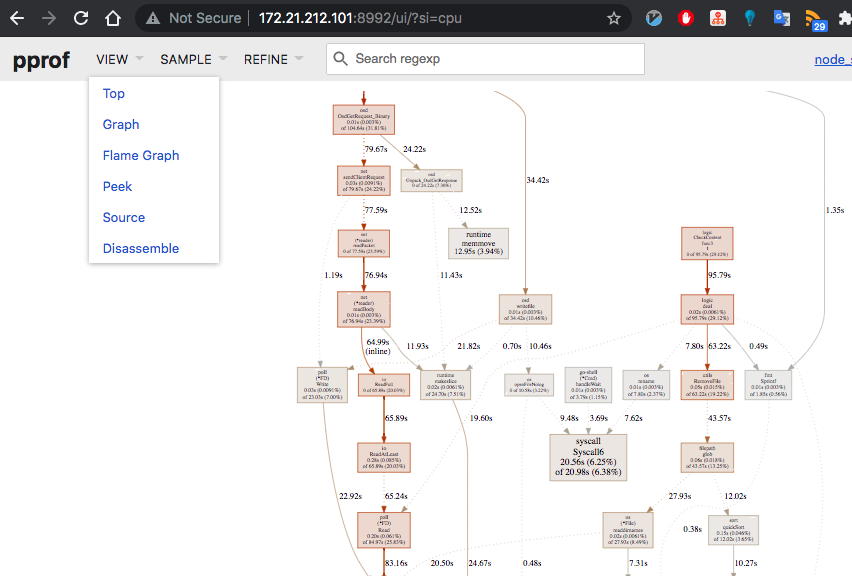

后来返现一种更易用的方式,服务在线上运行,本地浏览器直接打开调用图。

线上服务器ip为172.21.212.101,pprof监听端口为8991。

下面还是以cpu耗时为例

1 | [root@gw ~]# go tool pprof http://172.21.212.101:8991/debug/pprof/profile |

然后在线上服务器再起一个8992的端口

1 | [root@gw ~]# go tool pprof -http="172.21.212.101:8992" http://172.21.212.101:8991/debug/pprof/profile |

在本地浏览器可以直接打开web UI

还有火焰图,汇编代码等,功能更加强大。

As of Go 1.11, flamegraph visualizations are available in go tool pprof directly!

This will listen on :8081 and open a browser.

Change :8081 to a port of your choice.

$ go tool pprof -http=”:8081” [binary] [profile]

If you cannot use Go 1.11, you can get the latest pprof tool and use it instead:

Get the pprof tool directly

$ go get -u github.com/google/pprof

$ pprof -http=”:8081” [binary] [profile]

由于我的Mac上用的是go1.8.1版本,所用pprof命令。

1 | ➜ uhost-go git:(from_pxu) ✗ pprof uhost_server pprof.uhost_server.samples.cpu.004.pb |

以后用到了再整理,这里mark下

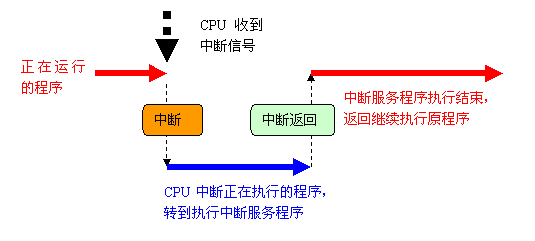

中断使得硬件可以发松通知给处理器。例如敲击键盘时,键盘就会产生一个中断,通知操作系统有键被按下。

中断本质上是一种电信号,由硬件设备生成,送入中断控制器的输入引脚中。中断控制器(如8259A)是个简单的电子芯片,将多路中断管线,采用复用技术只通过一个和处理器连接的管线和处理器通信。当产生一个中断后,处理器会检测到一个电信号,中断自己的当前正在运行的程序,通知内核。内核调用一个称为中断处理程序(interrupt handler)或中断服务例程(interrupt service routine)的特定程序。中断处理程序或中断服务例程可以在中断向量表中找到,而这个中断向量表位于内存中的固定地址中。CPU处理中断后,就会恢复执行之前被中断的程序,整个流程如下图所示。

不同设备同时中断如何知道哪个中断是来自硬盘、哪个来自网卡呢?这个很容易,系统上的每个硬件设备都会被分配一个 IRQ 号,通过这个唯一的IRQ号就能区别不同硬件设备了。

常见的中断控制器有两种:可编程中断控制器 8259A 和高级可编程中断控制器(APIC, Advanced Programmable Interrupt Controller),中断控制器应该在大学的硬件接口和计算机体系结构的相关课程中都学过。传统的 8259A 只适合单 CPU 的情况,现在都是多CPU多核的SMP体系,所以为了充分利用SMP体系结构、把中断传递给系统上的每个CPU 以便更好实现并行和提高性能,Intel 引入了高级可编程中断控制器(APIC)。

由于中断会频繁发生,因此要求中断处理程序执行要快速。为了实现快速执行,必须要将一些繁重且不非常紧急的任务从中断处理程序中剥离出来,这一部分Linux中称为下半部,有三种方法处理下半部——软中断、tasklet和工作队列。

内核如何从网卡接受数据,传统的经典过程:

但是,这一种方法,有一种重要的问题,就是大流量的数据来到,网卡会产生大量的中断,内核在中断上下文中,会浪费大量的资源来处理中断本身。所以,一个问题是,“可不可以不使用中断”,这就是轮询技术,所谓NAPI技术,说来也不神秘,就是说,内核屏蔽中断,然后隔一会儿就去问网卡,“你有没有数据啊?”

从这个描述本身可以看到,哪果数据量少,轮询同样占用大量的不必要的CPU资源,大家各有所长吧,呵呵……

OK,另一个问题,就是从网卡的I/O区域,包括I/O寄存器或I/O内存中去读取数据,这都要CPU去读,也要占用CPU资源,“CPU从I/O区域读,然后把它放到内存(这个内存指的是系统本身的物理内存,跟外设的内存不相干,也叫主内存)中”。于是自然地,就想到了DMA技术——让网卡直接从主内存之间读写它们的I/O数据,CPU,这儿不干你事,自己找乐子去:

剩下的处理和操作数据包的工作就会交给软中断。高负载的网卡是软中断产生的大户,很容易形成瓶颈。

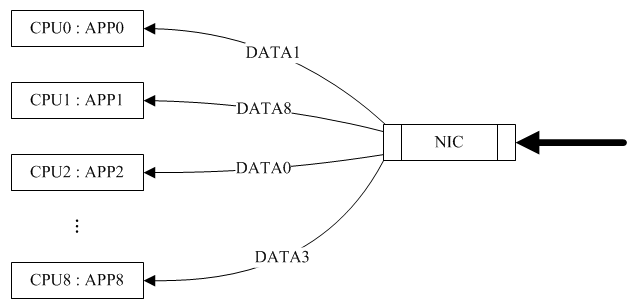

在相当长的时间内,网卡的中断都是通过CPU 0来处理的,造成CPU 0的压力很高、其他CPU相对空闲的情况。直到网卡多队列技术的出现,网卡多队列实际就是网卡的数据请求可以通过多个CPU处理。

常见的有Intel的82575、82576,Boardcom的57711等,下面以公司的服务器使用较多的Intel 82575网卡为例,分析一下多队列网卡的硬件的实现以及Linux内核软件的支持。

Intel 82575硬件逻辑图,有四个硬件队列。当收到报文时,通过hash包头的SIP、Sport、DIP、Dport四元组,将一条流总是收到相同的队列。同时触发与该队列绑定的中断。

RSS(Receive-Side Scaling, also known as multi-queue receive),是网卡的硬件特性,实现多队列,将不同的流分发到不同的CPU上,同一数据流始终在同一CPU上,避免TCP的顺序性和CPU的并行性发生冲突。

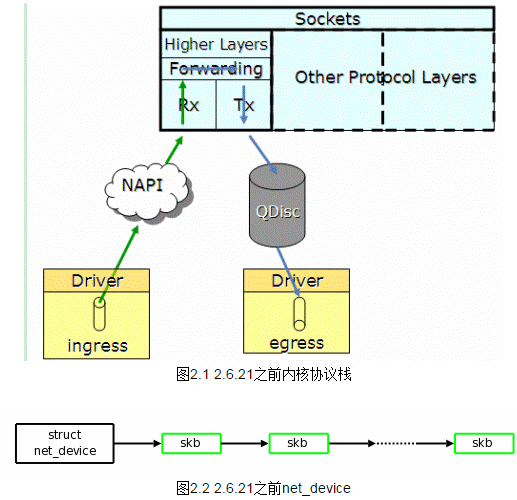

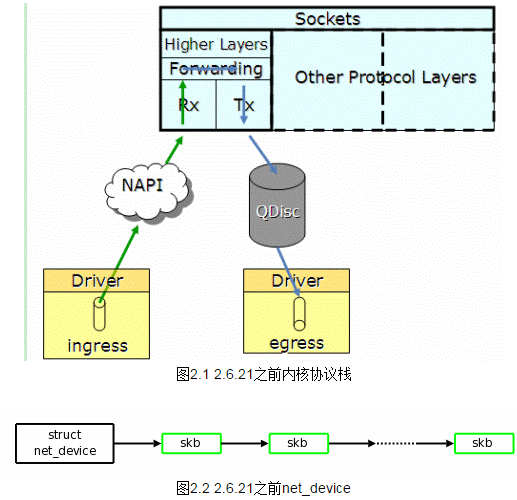

Linux kernel从2.6.21之前不支持多队列特性,一个网卡只能申请一个中断号,因此同一个时刻只有一个核在处理网卡收到的包。如图2.1,协议栈通过NAPI轮询收取各个硬件queue中的报文到图2.2的net_device数据结构中,通过QDisc队列将报文发送到网卡。

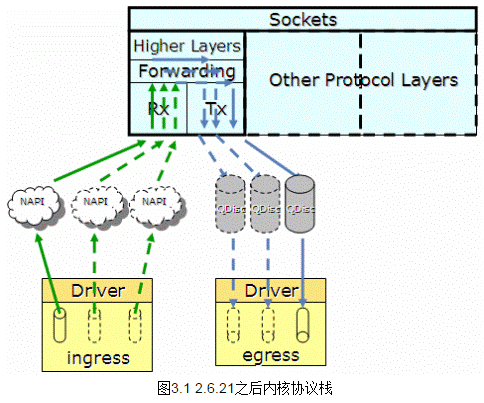

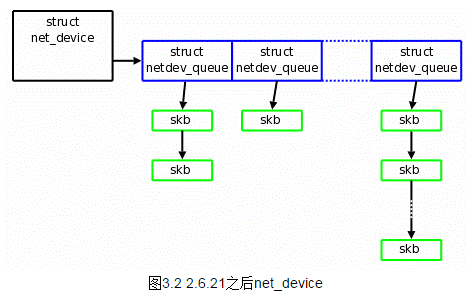

Linux kernel 2.6.21开始支持多队列特性,当网卡驱动加载时,通过获取的网卡型号,得到网卡的硬件queue的数量,并结合CPU核的数量,最终通过Sum=Min(网卡queue,CPU core)得出所要激活的网卡queue数量(Sum),并申请Sum个中断号,分配给激活的各个queue。

如图3.1,当某个queue收到报文时,触发相应的中断,收到中断的核,将该任务加入到协议栈负责收包的该核的NET_RX_SOFTIRQ队列中(NET_RX_SOFTIRQ在每个核上都有一个实例),在NET_RX_SOFTIRQ中,调用NAPI的收包接口,将报文收到CPU中如图3.2的有多个netdev_queue的net_device数据结构中。这样,CPU的各个核可以并发的收包,就不会因为一个核不能满足需求,导致网络IO性能下降。

但当CPU可以平行收包时,就会出现不同的核收取了同一个queue的报文,这就会产生报文乱序的问题,解决方法是将一个queue的中断绑定到唯一的一个核上去,从而避免了乱序的问题。

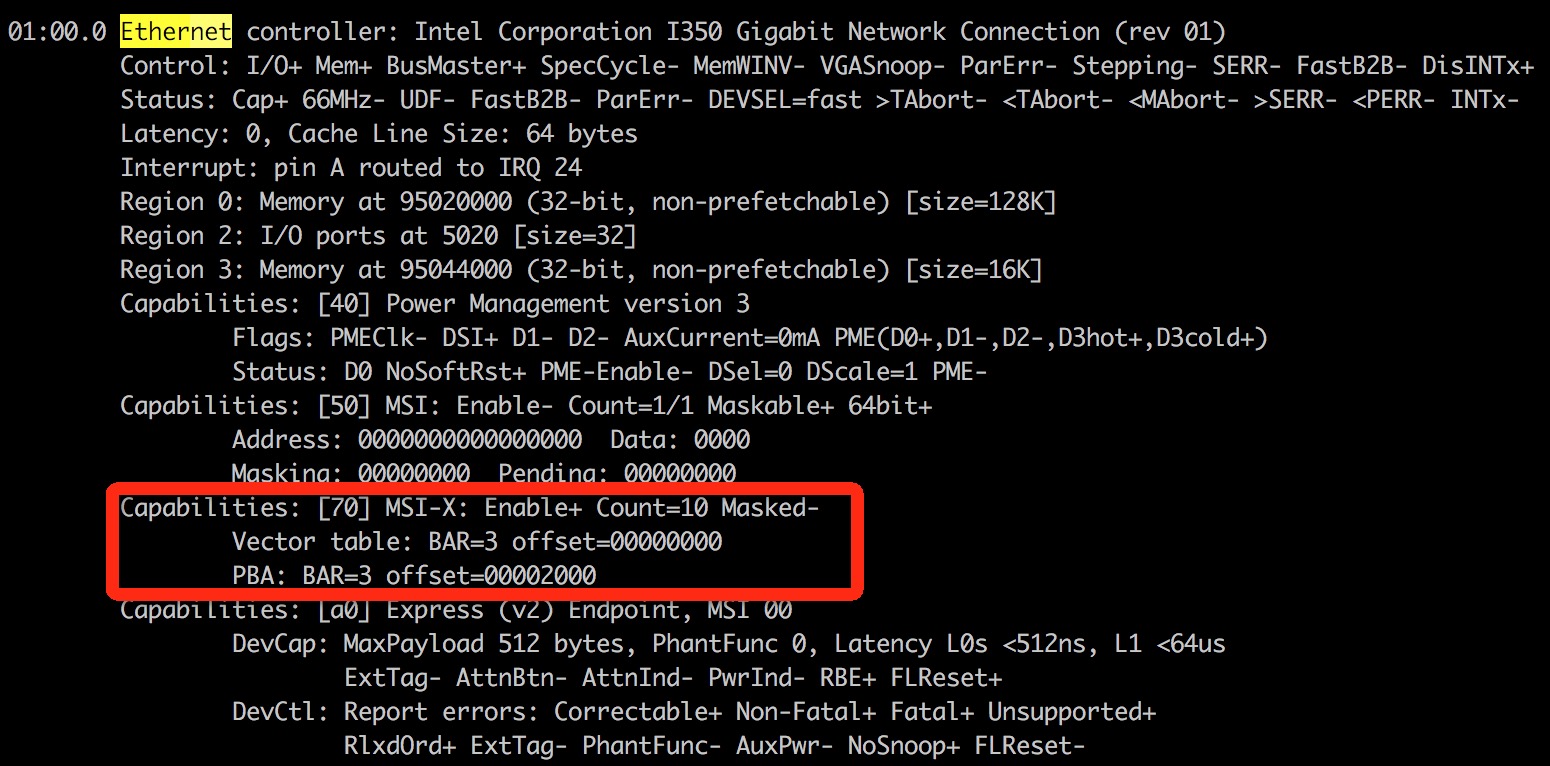

查看网卡是否支持多队列,使用lspci -vvv命令,找到Ethernet controller项:

如果有MSI-X, Enable+ 并且Count > 1,则该网卡是多队列网卡。

Message Signaled Interrupts(MSI)是PCI规范的一个实现,可以突破CPU 256条interrupt的限制,使每个设备具有多个中断线变成可能,多队列网卡驱动给每个queue申请了MSI。MSI-X是MSI数组,实际应用场景中,MSI方式的中断对多核cpu的利用情况不佳,网卡中断全部落在某一个cpu上,即使设置cpu affinity也没有作用,而MSI-X中断方式可以自动在多个cpu上分担中断

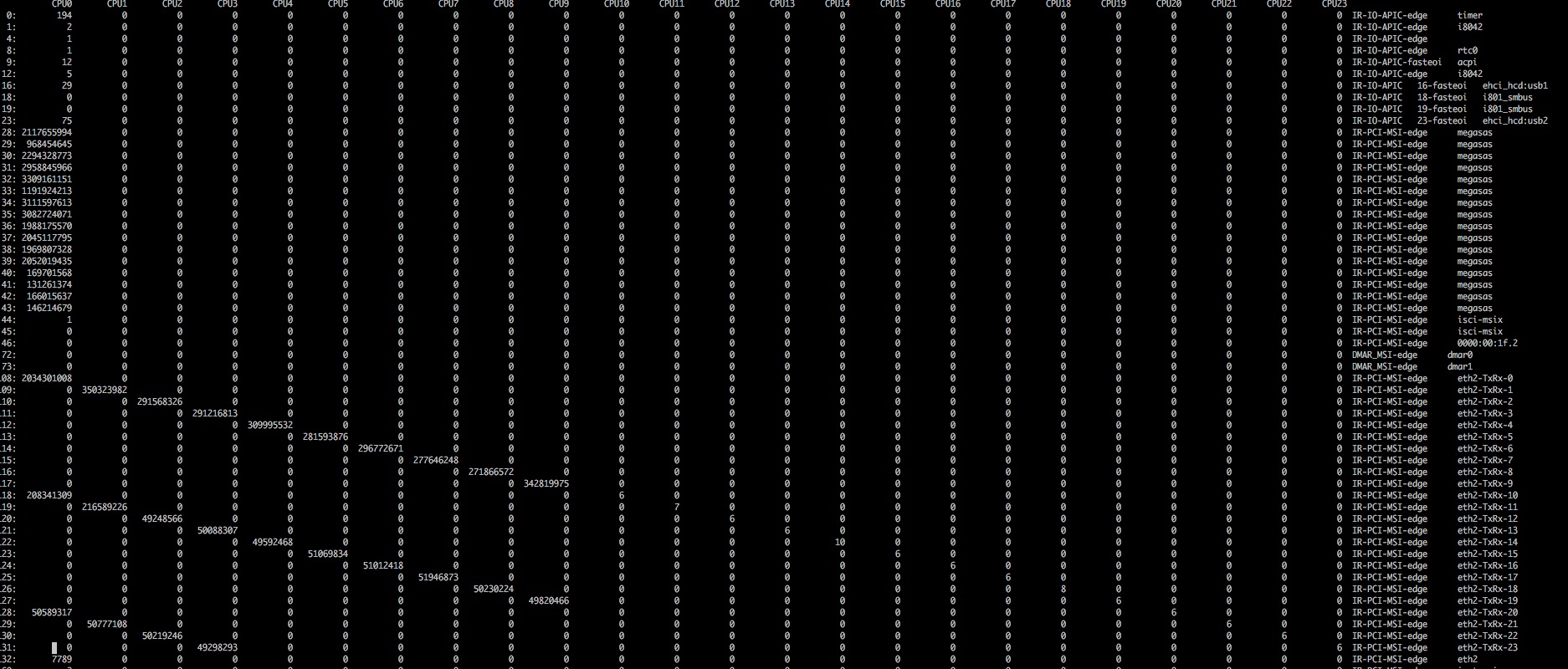

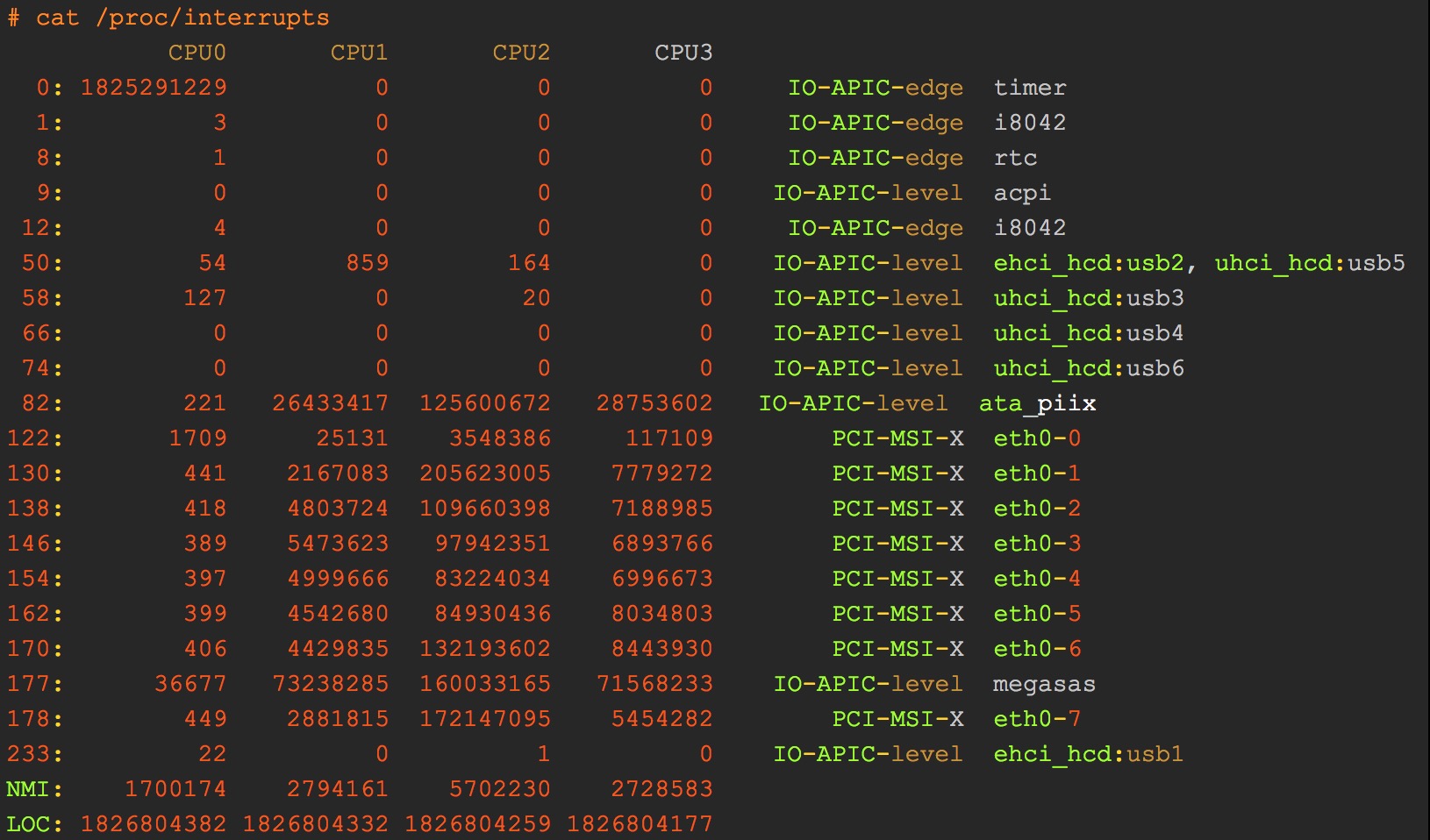

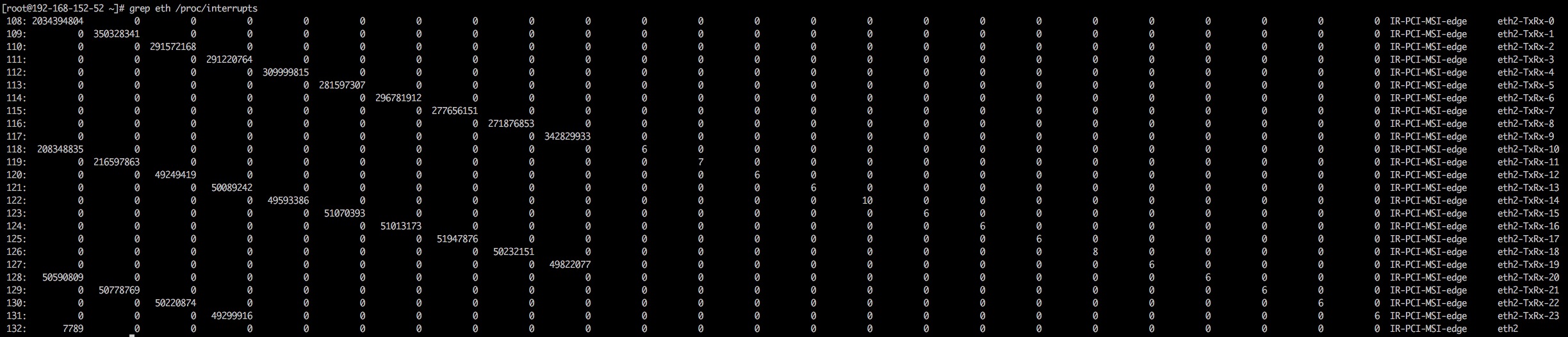

然后可以查看是否打开了网卡多队列,使用命令cat /proc/interrupts,如果看到如下图信息表明多队列支持已经打开:

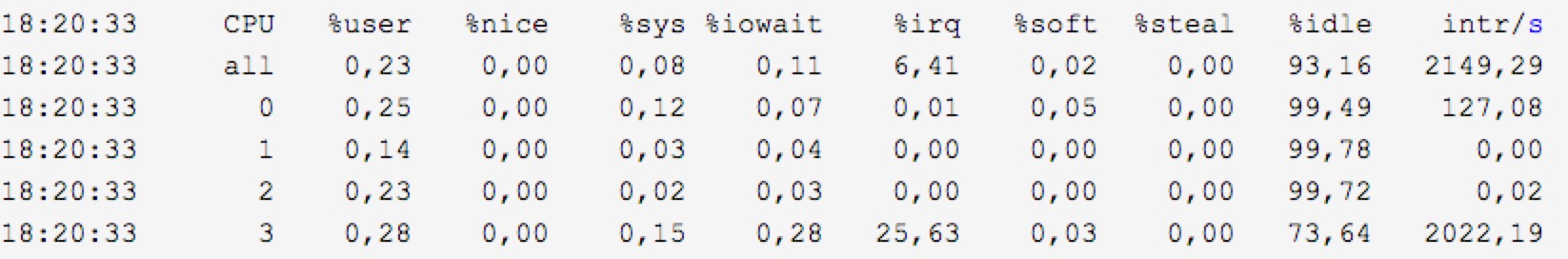

这个问题我们可以从 mpstat -P ALL 1 的输出中查明:里面的 %irq一列即说明了CPU忙于处理中断的时间占比

上面的例子中,第四个CPU有25.63%时间在忙于处理中断(这个数值还不算高,如果高达80%(而同时其它CPU这个数值很低)以上就说明有问题了),后面那个 intr/s 也说明了CPU每秒处理的中断数(从上面的数据也可以看出,其它几个CPU都不怎么处理中断)。

然后我们就要接着查另外一个问题:这个忙于处理中断的CPU都在处理哪个(些)中断?这要看/proc/interrupts文件

这里记录的是自启动以来,每个CPU处理各类中断的数量(第一列是中断号,最后一列是对应的设备名)

对上面文件的输出,解释如下:

● 第一列表示IRQ号。

● 第二、三、四列表示相应的CPU核心被中断的次数。在上面的例子中,timer表示中断名称(为系统时钟)。1825291229表示CPU0被中断了1825291229次。i8042表示控制键盘和鼠标的键盘控制器。

● 对于像rtc(real time clock)这样的中断,CPU是不会被中断的。因为RTC存在于电子设备中,是用于追踪时间的。

● NMI和LOC是系统所使用的驱动,用户无法访问和配置。

IRQ号决定了需要被CPU处理的优先级,IRQ号越小意味着优先级越高。

例如,如果CPU同时接收了来自键盘和系统时钟的中断,那么CPU首先会服务于系统时钟,因为他的IRQ号是0。

● IRQ0 :系统时钟(不能改变)。

● IRQ1 :键盘控制器(不能改变)。

● IRQ3 :串口2的串口控制器(如有串口4,则其也使用这个中断)。

● IRQ4 :串口1的串口控制器(如有串口3,则其也使用这个中断)。

● IRQ5 :并口2和3或声卡。

● IRQ6 :软盘控制器。

● IRQ7 : 并口1,它被用于打印机或若是没有打印机,可以用于任何的并口。

而对于像操作杆(或称为游戏手柄)上的CPU,它并不会等待设备发送中断。因为操作杆主要用于游戏,操作杆的移动必须非常快,因此使用轮询的方式检测设备是否需要CPU的关注还是比较理想的。使用轮询方式的缺点是CPU就处于了忙等状态,因为CPU会不停的多次检查设备。但是需要注意的是在Linux中,这种处理信号的方式也是必不可少的。

最后确认每个队列是否绑定到不同的CPU核心上,cat /proc/interrupts查询到每个队列的中断号,对应的文件/proc/irq/${IRQ_NUM}/smp_affinity为中断号IRQ_NUM绑定的CPU核的情况。以十六进制表示,每一位代表一个CPU核:

(00000001)代表CPU0

(00000010)代表CPU1

(00000011)代表CPU0和CPU1

SMP是指”对称多处理器”,smp_affinity文件主要用于某个特定IRQ要绑定到哪个CPU核心上。在 /proc/irq/IRQ_NUMBER/目录下都有一个smp_affinity文件,例如,网卡的中断号是:

1 | [root@192-168-152-52 ~]# cat /proc/irq/108/smp_affinity |

上面说明网卡队列绑定在CPU0~CPU0上。我们可以通过手动改变smp_affinity文件中的值来将IRQ绑定到指定的CPU核心上,或者启用irqbalance服务来自动绑定IRQ到CPU核心上。

Irqbalance是一个Linux的实用程序,它主要是用于分发中断请求到CPU核心上,有助于性能的提升。它的目的是寻求省电和性能优化之间的平衡。你可以使用yum进行安装(CentOS系统一般默认安装):

1 | yum -y install irqbalance |

Irqbalance对于包含多个核心的系统来说是非常有用的,因为通常中断只被第一个CPU核心服务。

● 动态监控CPU中断情况,观察中断变化

1 | watch -d -n 1 cat /proc/interrupts |

● 查看网卡中断相关信息

1 | cat /proc/interrupts | grep -E “eth|CPU” |

● 网卡亲和性设置

修改proc/irq/irq_number/smp_affinity之前,先停掉irq自动调节服务,不然修改的值就会被覆盖。

1 | /etc/init.d/irqbalance stop |

通过查看网卡中断相关信息,得到网卡中断为19

1 | [root@master ~]# cd /proc/irq/19 |

修改值,将19号中断绑定在cpu2上:

1 | [root@master 19]# echo 4 > smp_affinity |

如果是要将网卡中断绑定在cpu0和cpu2上怎么做了?请先参照上文中的CPU列表。cpu0和2的十六进制值分别为1,4。那么如果要同时绑定在cpu0和cpu2上,则十六进制值为5,如下:

1 | [root@master 19]# echo 5 > smp_affinity |

查看某个进程的CPU亲和性

1 | # taskset -p 30011 |

设置某个进程的CPU亲和性

1 | # taskset -p 1 30011 |

使用-c选项可以将一个进程对应到多个CPU上去

1 | # taskset -p -c 1,3 30011 |

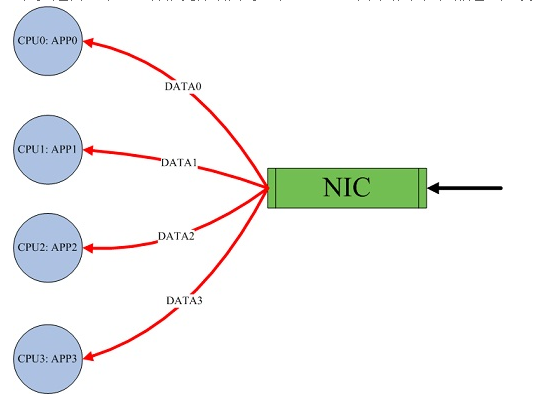

前面大量介绍了多队列网卡及中断绑定,但是在单网卡单队列的情况下要想负载做网卡软中断绑定怎么办呢?RPS/RFS就是为此而生的,RPS/RFS功能出现在Linux kernel 2.6.35中,由google的工程师提交的两个补丁,这两个补丁的出现主要功能是在单队列网卡的情况下,在系统层用模拟了多队列的情况,以便达到CPU的均衡。

RPS(Receive Packet Steering)主要是把软中断的负载均衡到各个cpu,简单来说,是网卡驱动对每个流生成一个hash标识,这个HASH值得计算可以通过四元组来计算(SIP,SPORT,DIP,DPORT),然后由中断处理的地方根据这个hash标识分配到相应的CPU上去,这样就可以比较充分的发挥多核的能力了。通俗点来说就是在软件层面模拟实现硬件的多队列网卡功能,如果网卡本身支持多队列功能的话RPS就不会有任何的作用。该功能主要针对单队列网卡多CPU环境,如网卡支持多队列则可使用SMP irq affinity直接绑定硬中断。

由于RPS只是单纯把数据包均衡到不同的cpu,这个时候如果应用程序所在的cpu和软中断处理的cpu不是同一个,此时对于cpu cache的影响会很大,那么RFS(Receive flow steering)确保应用程序处理的cpu跟软中断处理的cpu是同一个,这样就充分利用cpu的cache,这两个补丁往往都是一起设置,来达到最好的优化效果, 主要是针对单队列网卡多CPU环境。

网卡软中断分发的软件解决方法RPS/RFS

RSS需要网卡硬件的支持,在使用不支持RSS的网卡时,为了充分利用多核cpu,centos6.1开始提供了RPS(Receive Packet Steering)和RFS(Receive Flow Steering)。

RPS使网卡可以把一个rx队列的软中断分发到多个cpu核上,从而达到负载均衡的目的。RFS是RPS的扩展,RPS只依靠hash来控制数据包,提供了好的负载平衡,但是它没有考虑应用程序的位置(注:这个位置是指程序在哪个cpu上执行)。RFS则考虑到了应用程序的位置。RFS的目标是通过指派应用线程正在运行的CPU来进行数据包处理,以此来增加数据缓存的命中率。

待整理。。。。

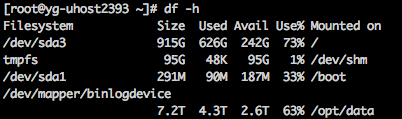

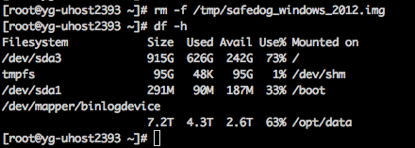

在删除文件后,有时会遇到磁盘空间并未被释放的场景。这里自己尝试复现,并去做相关的说明。

根目录下当前占用空间是626G。

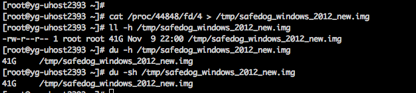

创建的文件/tmp/safedog_windows_2012_new.img占了15G。(ls和du的区别留到后面讲)

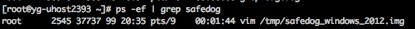

这里用vim打开文件,让有个进程一直在使用这个文件。

删除文件后,空间并未释放。

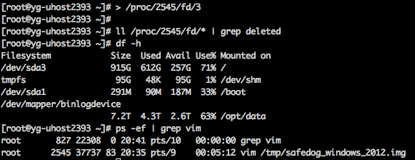

原因分析:

一个文件在文件系统中的存放分为两个部分:数据部分和指针部分,指针位于文件系统的meta-data中,数据被删除后,这个指针就从meta-data中清除了,而数据部分存储在磁盘中,数据对应的指针从meta-data中清除后,文件数据部分占用的空间就可以被覆盖并写入新的内容,之所以出现删除文件后,空间还没释放,就是因为有进程还在一直向这个文件写入内容,导致虽然删除了文件,但文件对应的指针部分由于进程锁定,并未从meta-data中清除,而由于指针并未被删除,那么系统内核就认为文件并未被删除,因此通过df命令查询空间并未释放也就不足为奇了。

重启或停止进程后,系统会自动回收

Alternatively, it is possible to force the system to de-allocate the space consumed by an in-use file by forcing the system to truncate the file via the proc file system. This is an advanced technique and should only be carried out when the administrator is certain that this will cause no adverse effects to running processes. Applications may not be designed to deal elegantly with this situation and may produce inconsistent or undefined behavior when files that are in use are abruptly truncated in this manner.

1 | > /proc/$pid/fd/$fd_number |

// 以上截断命令的区别

1 | > /proc/$pid/fd/$fd_number //截断后占据空间为0 |

以下直接操作文件名均不起作用

1 | > /tmp/safedog_windows_2012.img //不起作用 |

1 | cp /proc/44848/fd/4 /tmp/safedog_windows_2012_new.img1 //方法1 |

恢复的文件占用空间还会更大,是否恢复出来的已经不是稀疏的了?后面待解释

比较文件的一致性

1 | diff /tmp/safedog_windows_2012_new.img1 /tmp/safedog_windows_2012_new.img2 |

Why is space not being freed from disk after deleting a file in Red Hat Enterprise Linux?

go中根据首字母的大小写来确定可以访问的权限。如果首字母大写,则可以被其他的包访问;如果首字母小写,则只能在本包中使用。包括接口、类型、函数和变量等。

可以简单的理解成,首字母大写是公有的,首字母小写是私有的

下面是一个排查该问题的例子:

1 | package main |

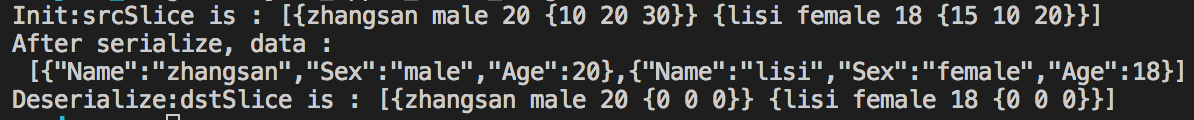

很意外的是,我们反序列化后获取的对象数据dstSliece是错误的,Position里的数据都变成了0。而json.Unmarshal没有返回任何异常。

观察将序列化后的json串,Position的数据丢了,这使得我们想到了可见性,即大写的符号在包外可见。通过走查代码,我们发现Student的定义中,Position的变量名是小写开始的。

1 | type Student struct { |

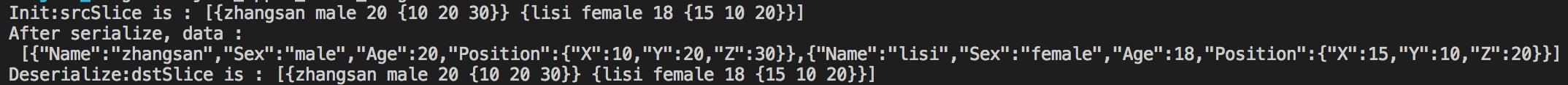

改成大写后再观察结果,可以正常序列化。

对于json串,很多人喜欢全小写,对于大写开头的key感觉很刺眼,我们继续改进:

1 | type Position struct { |

再次运行程序,结果是我们期望的,打印如下:

1 | Init:srcSlice is : [{zhangsan male 20 {10 20 30}} {lisi female 18 {15 10 20}}] |

1 | type Dog struct { |

1 | func main() { |

output:

1 | {"Breed":"dalmation","WeightKg":45} |

如果对dog没有设置:

1 | func main() { |

这会输出

1 | {"Breed":"pug","WeightKg":0} |

即使WeightKg的值是未知的。

更好的方式是使“WeightKg”为null, 或者根本没有这个值。

omitempty tag 正好可以起到这个作用.

1 | type Dog struct { |

这会输出

1 | {"Breed":"pug"} |

参考这里,已经很详细了 HTTP Keep-Alive是什么?如何工作?

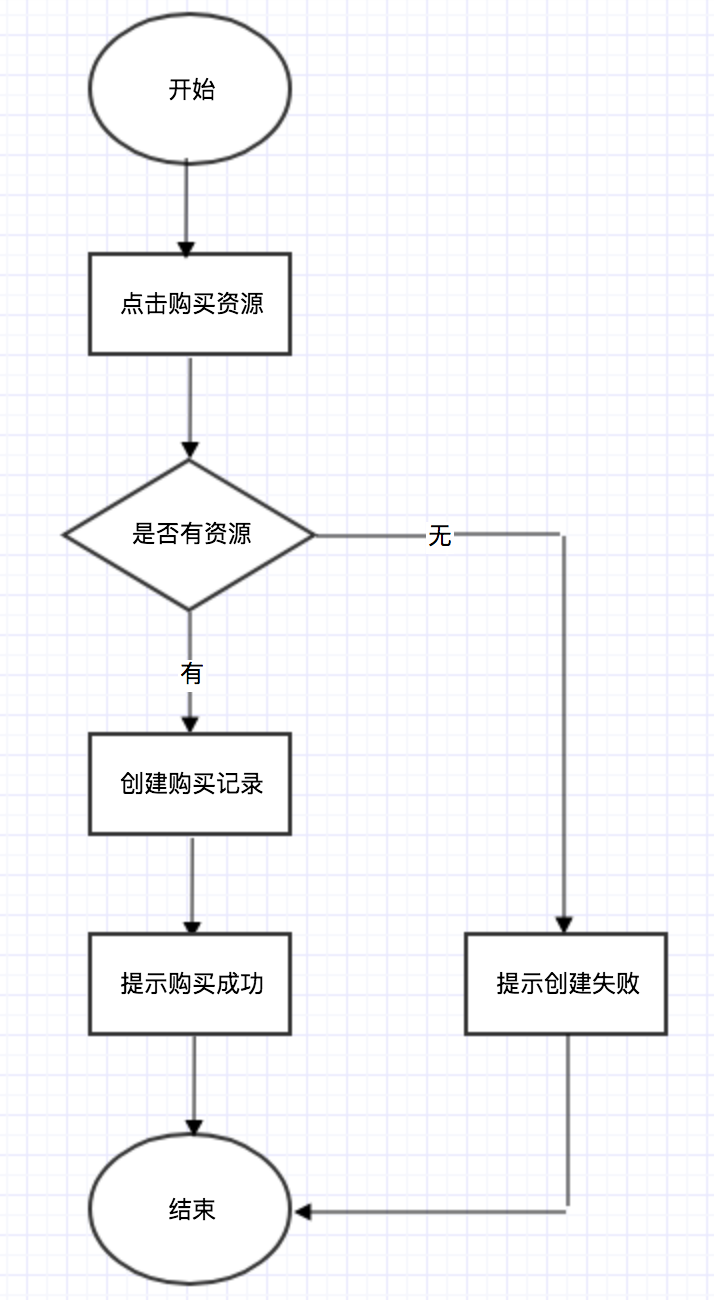

秒杀场景,多人并发申请购买同一种商品。

下面以2人抢购同一件商品举例,商品数量为1。

基本流程如下:

这个流程中存在明显的并发问题,当进程A查看有1个商品,但未开始创建购买记录,此时另一个进程B也进行了资源检查,发现有1个商品,顺利通过,并完成购买操作,此时A继续执行,则1个商品会产生两条购买的记录。(这个并发场景很简单,很普遍)

解决方案通常是2类:

1 通过将请求分发到不同set,减少并发的可能性,分而治之。这里暂时不讨论。

2 当收到并发请求时,如何处理。

a. 锁库存

b. 插入“秒杀”记录

c. 更新库存

“秒杀”系统的设计难点就在这个事务操作上。商品库存在DB中记为一行,大量用户同时“秒杀”同一商品时,第一个到达DB的请求锁住了这行库存记录。在第一个事务完成提交之前这个锁一直被第一个请求占用,其他到达的请求全部失败。

加锁的方案,效率会比较低。实际应用时,通常要配合排队系统,让没有获取到锁的请求排队。

排队模块接收用户的抢红包请求,以FIFO模式保存下来,调度模块负责FIFO队列的动态调度,一旦有空闲资源,便从队列头部把用户的访问请求取出后交给真正提供服务的模块处理。优点是,具有中心节点的统一资源管理,对系统的可控性强,可深度定制。缺点是,所有请求流量都会有中心节点参与,效率必然会比分布式无中心系统低,并且,中心节点也很容易成为整个系统的性能瓶颈。

参考

https://www.ibm.com/developerworks/cn/web/wa-design-small-and-good-kill-system/index.html

https://blog.csdn.net/zhanjianshinian/article/details/53342730

每件商品以一个数字ID来标识,这个ID是全局唯一的,所有围绕商品的操作都使用这个ID作为数据的关联项。

Redis节点内存储的是这个分组可以分发的商品ID号段,利用Redis特性实现红包分发,各服务节点通过Redis原语获取当前拆到的红包。这种做法的思路是,Redis 本身是单进程工作模型,来自分布式系统各个节点的操作请求天然的被 Redis Server 做了一个同步队列,只要每个请求执行的足够快,这个队列就不会引起阻塞及请求超时。而本例中我们使用了 DECR 原语,性能上是可以满足需求的。Redis 在这里相当于是充当一个分布式序号发生器的功能,分发红包 ID。

https://blog.csdn.net/echo3/article/details/17580347 使用memcached进行并发控制(写的非常好)

http://www.infoq.com/cn/articles/2017hongbao-weixin# 百亿级微信红包的高并发资金交易系统设计方案

https://blog.csdn.net/yanker1990/article/details/78737626 Memcache的并发问题和利用CAS的解决方案

如何设计一个小而美的秒杀系统?

https://www.ibm.com/developerworks/cn/web/wa-design-small-and-good-kill-system/index.html

使用memcached进行并发控制(写的非常好)

https://blog.csdn.net/echo3/article/details/17580347

电商秒杀系统设计分析

https://blog.csdn.net/zhanjianshinian/article/details/53342730

https://memcached.org/about

Redis DECR命令

https://www.kancloud.cn/thinkphp/redis-quickstart/36180

云主机的问题:

申请时要排队,好像没有意义。

防止申请到同一台宿主机,前面做的临时添加资源是否有用。跟定时更新是否有冲突?

参照官网文档 https://golang.org/doc/install

可以在命令行中输入命令来验证是否安装成功:

2个环境变量,即 GOROOT、GOPATH和GOBIN: